大数据项目实战最新版 基于Hadoop+Django的用户贷款行为数据分析系统 毕业设计|选题推荐|深度学习|数据分析|数据挖掘|机器学习|随机森林|大屏|预测

大数据项目实战最新版 基于Hadoop+Django的用户贷款行为数据分析系统 毕业设计|选题推荐|深度学习|数据分析|数据挖掘|机器学习|随机森林|大屏|预测

✍✍计算机毕设指导师**

⭐⭐个人介绍:自己非常喜欢研究技术问题!专业做Java、Python、小程序、安卓、大数据、爬虫、Golang、大屏等实战项目。

⛽⛽实战项目:有源码或者技术上的问题欢迎在评论区一起讨论交流!

⚡⚡有什么问题可以在主页上或文末下联系咨询博客~~

⚡⚡Java、Python、小程序、大数据实战项目集](https://blog.csdn.net/2301_80395604/category_12487856.html)

⚡⚡文末获取源码

温馨提示:文末有CSDN平台官方提供的博客联系方式的名片!

温馨提示:文末有CSDN平台官方提供的博客联系方式的名片!

温馨提示:文末有CSDN平台官方提供的博客联系方式的名片!

文章目录

用户贷款行为数据分析系统-简介

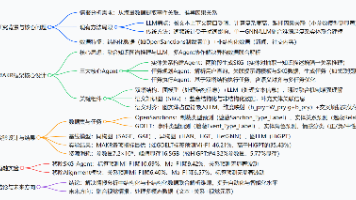

基于Hadoop+Django的用户贷款行为数据分析系统是一个集成了现代大数据技术栈的综合性数据分析平台,专门针对金融机构的用户贷款行为进行深度挖掘和风险预测。该系统采用Hadoop作为分布式存储和计算的核心框架,结合Spark进行大规模数据处理和分析,通过HDFS实现海量贷款数据的可靠存储。在技术架构上,系统支持Python+Django和Java+Spring Boot两套完整的开发方案,前端采用Vue+ElementUI+Echarts构建现代化的数据可视化界面,后端通过MySQL数据库进行结构化数据管理。系统功能涵盖三个核心阶段:首先是数据清洗与预处理阶段,利用PySpark对原始贷款数据进行格式规范化、缺失值处理和异常值检测;其次是数据处理与特征工程阶段,通过Spark SQL和Pandas进行特征转换、衍生新特征并完成特征选择;最后是多维度数据分析与建模阶段,从用户基本画像、收入年龄、职业工作、地理位置等多个维度进行深入分析,并构建机器学习模型实现贷款违约预测。整个系统充分发挥了Hadoop生态系统的优势,结合NumPy进行数值计算,通过Spark SQL实现复杂的数据查询和统计分析,最终输出包括婚姻状况分析、房屋所有权分析、收入水平分析、职业分析等多份详细的分析报告,为金融机构提供全面的用户画像和风险评估依据。

用户贷款行为数据分析系统-技术

大数据框架:Hadoop+Spark(本次没用Hive,支持定制)

开发语言:Python+Java(两个版本都支持)

后端框架:Django+Spring Boot(Spring+SpringMVC+Mybatis)(两个版本都支持)

前端:Vue+ElementUI+Echarts+HTML+CSS+JavaScript+jQuery

数据库:MySQL

用户贷款行为数据分析系统-背景

选题背景

随着金融科技的快速发展,中国消费信贷市场规模持续扩张,据中国人民银行统计数据显示,截至2023年末,全国个人消费贷款余额达到58.24万亿元,同比增长7.3%,其中互联网消费金融贷款占比超过30%。与此同时,银保监会发布的《2023年银行业金融机构资产质量报告》显示,个人消费贷款不良率为1.02%,虽然整体可控,但局部风险仍然存在。在这样的市场环境下,传统的风控模式已经无法满足海量用户数据的处理需求,金融机构迫切需要借助大数据技术来提升风险识别能力。艾瑞咨询发布的《中国金融科技行业研究报告2023》指出,超过85%的金融机构已经将大数据分析作为风控体系的核心组成部分,而基于用户行为数据的智能风控系统能够将风险识别准确率提升至92%以上。面对日益复杂的贷款申请场景和多元化的用户群体,如何有效整合和分析海量的用户行为数据,构建精准的风险预测模型,已经成为金融行业亟待解决的重要课题。

选题意义

本课题的研究具有重要的理论价值和实际应用意义。从技术角度来看,通过整合Hadoop分布式计算框架和Spark大数据处理引擎,能够有效解决传统数据分析工具在处理海量贷款数据时遇到的性能瓶颈问题,为大数据在金融风控领域的应用提供了可行的技术路径。该系统通过多维度的用户行为分析,包括用户画像构建、收入水平评估、职业风险分析等,能够帮助金融机构更加全面地了解借贷用户的真实风险状况,显著提升贷款审批的科学性和准确性。从实际应用层面而言,该系统的投入使用可以有效降低金融机构的坏账损失,提高资产质量,同时通过智能化的风险评估模式,能够为符合条件的用户提供更加便捷高效的贷款服务,促进普惠金融的发展。对于金融监管部门来说,该系统产生的分析结果和风险预警信息,可以为制定更加精准的监管政策提供数据支撑,有助于维护金融市场的稳定运行,推动整个行业向着更加健康可持续的方向发展。

用户贷款行为数据分析系统-视频展示

大数据项目实战最新版 基于Hadoop+Django的用户贷款行为数据分析系统 毕业设计|选题推荐|深度学习|数据分析|数据挖掘|机器学习|随机森林|大屏|预测

用户贷款行为数据分析系统-图片展示

用户贷款行为数据分析系统-代码展示

# 核心功能1:数据清洗与预处理

def data_cleaning_and_preprocessing(file_path):

spark = SparkSession.builder.appName("LoanDataCleaning").getOrCreate()

df = spark.read.csv(file_path, header=True, inferSchema=True)

# 规范化列名,处理特殊字符

df = df.withColumnRenamed("Married/Single", "Marital_Status")

# 清洗城市字段,移除方括号和数字

df = df.withColumn("CITY", regexp_replace(col("CITY"), r"\[\d+\]", ""))

# 处理缺失值:数值型用0填充,字符型用"未知"填充

numeric_cols = ["Age", "Experience", "Income", "CURRENT_JOB_YRS"]

string_cols = ["CITY", "STATE", "Marital_Status", "House_Ownership", "Car_Ownership", "Profession"]

for col_name in numeric_cols:

df = df.fillna({col_name: 0})

for col_name in string_cols:

df = df.fillna({col_name: "未知"})

# 异常值处理:工作经验不能超过年龄

df = df.withColumn("Experience", when(col("Experience") > col("Age"), col("Age")).otherwise(col("Experience")))

# 当前工作年限不能超过总经验

df = df.withColumn("CURRENT_JOB_YRS", when(col("CURRENT_JOB_YRS") > col("Experience"), col("Experience")).otherwise(col("CURRENT_JOB_YRS")))

# 年龄合理性检查(18-80岁)

df = df.filter((col("Age") >= 18) & (col("Age") <= 80))

# 收入合理性检查(大于0)

df = df.filter(col("Income") > 0)

# 保存清洗后的数据

cleaned_df = df.cache()

cleaned_df.write.mode("overwrite").csv("cleaned_loan_data", header=True)

return cleaned_df

# 核心功能2:多维度数据分析

def multi_dimensional_analysis(cleaned_df):

spark = SparkSession.builder.appName("LoanDataAnalysis").getOrCreate()

# 用户基本画像分析 - 婚姻状况

marital_analysis = cleaned_df.groupBy("Marital_Status", "Risk_Flag").count().withColumnRenamed("count", "user_count")

marital_summary = marital_analysis.groupBy("Marital_Status").agg(

sum("user_count").alias("total_users"),

sum(when(col("Risk_Flag") == 1, col("user_count")).otherwise(0)).alias("risk_users")

).withColumn("risk_rate", round(col("risk_users") / col("total_users") * 100, 2))

# 收入水平分析

income_df = cleaned_df.withColumn("Income_Level",

when(col("Income") < 30000, "低收入")

.when(col("Income") < 80000, "中等收入")

.otherwise("高收入")

)

income_analysis = income_df.groupBy("Income_Level", "Risk_Flag").count().withColumnRenamed("count", "user_count")

income_summary = income_analysis.groupBy("Income_Level").agg(

sum("user_count").alias("total_users"),

sum(when(col("Risk_Flag") == 1, col("user_count")).otherwise(0)).alias("risk_users"),

avg(when(col("Risk_Flag") == 0, col("user_count")).otherwise(0)).alias("avg_safe_users")

).withColumn("risk_percentage", round(col("risk_users") / col("total_users") * 100, 2))

# 职业风险分析

profession_analysis = cleaned_df.groupBy("Profession").agg(

count("*").alias("total_count"),

sum("Risk_Flag").alias("risk_count"),

avg("Income").alias("avg_income"),

avg("Age").alias("avg_age"),

avg("Experience").alias("avg_experience")

).withColumn("risk_ratio", round(col("risk_count") / col("total_count") * 100, 2))

# 地理位置分析

state_analysis = cleaned_df.groupBy("STATE").agg(

count("*").alias("total_applications"),

sum("Risk_Flag").alias("high_risk_count"),

avg("Income").alias("average_income"),

countDistinct("CITY").alias("city_coverage")

).withColumn("state_risk_rate", round(col("high_risk_count") / col("total_applications") * 100, 2))

# 年龄分组分析

age_df = cleaned_df.withColumn("Age_Group",

when(col("Age") < 30, "青年")

.when(col("Age") < 50, "中年")

.otherwise("中老年")

)

age_analysis = age_df.groupBy("Age_Group").agg(

count("*").alias("group_size"),

sum("Risk_Flag").alias("risk_cases"),

avg("Income").alias("group_avg_income"),

max("Income").alias("group_max_income"),

min("Income").alias("group_min_income")

).withColumn("age_group_risk_rate", round(col("risk_cases") / col("group_size") * 100, 2))

# 保存分析结果

marital_summary.write.mode("overwrite").csv("marital_status_analysis", header=True)

income_summary.write.mode("overwrite").csv("income_level_analysis", header=True)

profession_analysis.write.mode("overwrite").csv("profession_analysis", header=True)

state_analysis.write.mode("overwrite").csv("state_analysis", header=True)

age_analysis.write.mode("overwrite").csv("age_group_analysis", header=True)

return {

"marital": marital_summary,

"income": income_summary,

"profession": profession_analysis,

"state": state_analysis,

"age": age_analysis

}

# 核心功能3:贷款违约预测模型构建

def build_prediction_model(cleaned_df):

spark = SparkSession.builder.appName("LoanPredictionModel").getOrCreate()

# 特征工程:字符串特征转换为数值

indexers = [StringIndexer(inputCol=column, outputCol=column+"_index").fit(cleaned_df)

for column in ["Marital_Status", "House_Ownership", "Car_Ownership", "Profession", "CITY", "STATE"]]

pipeline_stages = indexers

feature_pipeline = Pipeline(stages=pipeline_stages)

indexed_df = feature_pipeline.fit(cleaned_df).transform(cleaned_df)

# 组装特征向量

feature_cols = ["Age", "Experience", "Income", "CURRENT_JOB_YRS",

"Marital_Status_index", "House_Ownership_index", "Car_Ownership_index",

"Profession_index", "CITY_index", "STATE_index"]

assembler = VectorAssembler(inputCols=feature_cols, outputCol="features")

final_df = assembler.transform(indexed_df).select("features", "Risk_Flag")

# 数据标准化

scaler = StandardScaler(inputCol="features", outputCol="scaled_features")

scaler_model = scaler.fit(final_df)

scaled_df = scaler_model.transform(final_df).select("scaled_features", "Risk_Flag")

scaled_df = scaled_df.withColumnRenamed("scaled_features", "features")

# 划分训练集和测试集

train_df, test_df = scaled_df.randomSplit([0.8, 0.2], seed=123)

# 训练随机森林模型

rf = RandomForestClassifier(featuresCol="features", labelCol="Risk_Flag", numTrees=100, maxDepth=10)

rf_model = rf.fit(train_df)

# 模型预测

train_predictions = rf_model.transform(train_df)

test_predictions = rf_model.transform(test_df)

# 模型评估

evaluator_accuracy = MulticlassClassificationEvaluator(labelCol="Risk_Flag", predictionCol="prediction", metricName="accuracy")

evaluator_precision = MulticlassClassificationEvaluator(labelCol="Risk_Flag", predictionCol="prediction", metricName="weightedPrecision")

evaluator_recall = MulticlassClassificationEvaluator(labelCol="Risk_Flag", predictionCol="prediction", metricName="weightedRecall")

evaluator_f1 = MulticlassClassificationEvaluator(labelCol="Risk_Flag", predictionCol="prediction", metricName="f1")

train_accuracy = evaluator_accuracy.evaluate(train_predictions)

test_accuracy = evaluator_accuracy.evaluate(test_predictions)

test_precision = evaluator_precision.evaluate(test_predictions)

test_recall = evaluator_recall.evaluate(test_predictions)

test_f1 = evaluator_f1.evaluate(test_predictions)

# 特征重要性分析

feature_importance = rf_model.featureImportances.toArray()

importance_df = spark.createDataFrame(

[(feature_cols[i], float(feature_importance[i])) for i in range(len(feature_cols))],

["feature_name", "importance_score"]

).orderBy(desc("importance_score"))

# 创建评估结果数据框

evaluation_results = spark.createDataFrame([

("训练集准确率", train_accuracy),

("测试集准确率", test_accuracy),

("测试集精确率", test_precision),

("测试集召回率", test_recall),

("测试集F1分数", test_f1)

], ["metric_name", "metric_value"])

# 保存模型评估结果和特征重要性

evaluation_results.write.mode("overwrite").csv("model_evaluation", header=True)

importance_df.write.mode("overwrite").csv("feature_importance", header=True)

# 保存模型

rf_model.write().overwrite().save("loan_prediction_model")

return {

"model": rf_model,

"accuracy": test_accuracy,

"precision": test_precision,

"recall": test_recall,

"f1_score": test_f1,

"feature_importance": importance_df

}

用户贷款行为数据分析系统-结语

大数据项目实战最新版 基于Hadoop+Django的用户贷款行为数据分析系统 毕业设计|选题推荐|深度学习|数据分析|数据挖掘|机器学习|随机森林|大屏|预测

如果你觉得内容不错,欢迎一键三连(点赞、收藏、关注)支持一下!也欢迎在评论区或在博客主页上私信联系留下你的想法或提出宝贵意见,期待与大家交流探讨!谢谢!

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)