使用Xinference部署语音模型实现文本转语音:完整指南

通过Xinference部署语音合成模型,我们能够轻松实现高质量的文本转语音功能。简单易用的API接口支持多种语言和音色本地部署保障数据隐私高性能语音生成能力随着语音合成技术的不断发展,我们期待未来能够实现更加自然、富有表现力的语音合成效果。

·

引言

文本转语音(Text-to-Speech, TTS)技术在智能助手、有声读物、语音导航等应用中扮演着重要角色。本文将介绍如何利用Xinference框架部署高质量的语音合成模型(如CosyVoice-300M-SFT),并通过类似OpenAI的API接口实现文本转语音功能。

环境准备

1. 安装Xinference

pip install "xinference[all]"

2. 启动Xinference服务

# 启动服务(默认端口9997)

xinference-local

3. 部署语音模型

# 部署CosyVoice-300M模型

xinference launch --model-uid CosyVoice-300M-SFT --model-type audio --model-name CosyVoice-300M-SFT

Python实现文本转语音

import openai

from pydub import AudioSegment

from pydub.playback import play

import time

class TextToSpeechConverter:

def __init__(self, base_url="http://127.0.0.1:9998/v1", api_key="not-needed"):

self.client = openai.Client(api_key=api_key, base_url=base_url)

def text_to_speech(self, text, voice="中文女", output_file="output.mp3", play_audio=False):

"""

将文本转换为语音并保存为MP3文件

参数:

text: 要转换的文本

voice: 音色选择(中文女/中文男/日语男/粤语女/英文女/英文男/韩语女)

output_file: 输出文件名

play_audio: 是否立即播放生成的语音

"""

try:

print(f"正在生成语音: {text[:30]}...")

start_time = time.time()

# 调用TTS API

response = self.client.audio.speech.create(

model="CosyVoice-300M-SFT",

input=text,

voice=voice

)

# 保存语音文件

with open(output_file, 'wb') as f:

f.write(response.content)

process_time = time.time() - start_time

print(f"语音生成完成! 保存至 {output_file} (耗时: {process_time:.2f}秒)")

# 播放生成的语音

if play_audio:

self.play_audio(output_file)

return output_file

except Exception as e:

print(f"语音生成失败: {str(e)}")

return None

def play_audio(self, file_path):

"""播放生成的语音文件"""

try:

print(f"播放语音: {file_path}")

audio = AudioSegment.from_mp3(file_path)

play(audio)

except Exception as e:

print(f"播放失败: {str(e)}")

if __name__ == "__main__":

# 创建TTS转换器实例

tts = TextToSpeechConverter()

# 示例文本转换

samples = [

{"text": "欢迎使用语音合成系统,这是一个强大的文本转语音工具。", "voice": "中文女"},

{"text": "Hello, this is an English voice synthesis example.", "voice": "英文女"},

{"text": "こんにちは、これは日本語の音声合成デモです。", "voice": "日语男"},

{"text": "呢个系粤语语音合成嘅示范,好实用嘅功能!", "voice": "粤语女"},

]

for i, sample in enumerate(samples):

output_file = f"output_{i+1}.mp3"

tts.text_to_speech(

text=sample["text"],

voice=sample["voice"],

output_file=output_file,

play_audio=True

)

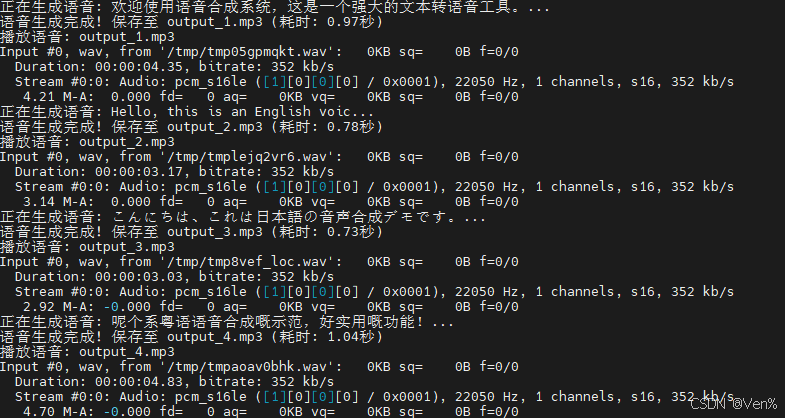

运行结果如下:

关键参数说明

-

音色选择:

中文女:标准普通话女声中文男:标准普通话男声粤语女:粤语女声日语男:日语男声英文女/男:英语女声/男声韩语女:韩语女声

-

模型参数:

model="CosyVoice-300M-SFT":指定使用的语音模型input:要转换的文本内容(支持中英文混合)

应用场景

- 智能客服系统:自动生成语音回复

- 有声内容创作:将文章/书籍转换为语音

- 语音导航系统:为导航应用生成实时语音提示

- 语言学习工具:提供多语言发音示范

- 辅助功能:为视障用户转换文本内容

性能优化建议

-

GPU加速:

# 启用GPU加速(需要CUDA环境) xinference-local --gpu -

批处理请求:

# 同时生成多个语音片段 texts = ["第一条消息", "第二条消息", "第三条消息"] for i, text in enumerate(texts): tts.text_to_speech(text, output_file=f"batch_{i}.mp3") -

长文本处理:

def split_long_text(text, max_length=200): """将长文本分割为适合处理的片段""" return [text[i:i+max_length] for i in range(0, len(text), max_length)] long_text = "这是一个很长的文本..." # 500+字符 segments = split_long_text(long_text) for i, segment in enumerate(segments): tts.text_to_speech(segment, output_file=f"segment_{i}.mp3")

常见问题解决

-

服务连接失败:

- 检查Xinference是否正常运行:

xinference status - 确认API地址是否正确(默认:http://localhost:9998/v1)

- 检查Xinference是否正常运行:

-

语音生成速度慢:

- 使用GPU加速:

xinference-local --gpu - 减少单次请求的文本长度

- 使用GPU加速:

-

音色不自然:

- 尝试不同音色选项

- 调整文本标点符号(适当添加停顿)

- 确保文本语言与音色匹配(如中文文本使用中文音色)

结语

通过Xinference部署语音合成模型,我们能够轻松实现高质量的文本转语音功能。本文提供的Python实现方案具有以下优势:

- 简单易用的API接口

- 支持多种语言和音色

- 本地部署保障数据隐私

- 高性能语音生成能力

随着语音合成技术的不断发展,我们期待未来能够实现更加自然、富有表现力的语音合成效果。

更多推荐

已为社区贡献18条内容

已为社区贡献18条内容

所有评论(0)