Java开发LLM大模型AI应用的破局之道

人工智能技术正以惊人的速度重塑各行各业,作为全球使用率最高的编程语言,Java在构建大模型AI应用时却面临独特挑战。

人工智能技术正以惊人的速度重塑各行各业,作为全球使用率最高的编程语言,Java在构建大模型AI应用时却面临独特挑战。

一、大模型对接的"万国语言"困境 不同大模型的接口协议如同各国方言:

OpenAI使用JSON-RPC,智谱AI偏好Protobuf,而文心一言则需要特定的SDK调用。更令人头疼的是,各家的令牌计算、流式响应处理方式也千差万别。曾有团队为同时接入三个大模型,耗费两个月编写适配层代码。

破局关键:

统一接入层设计:JBoltAI的ModelRouter模块采用自适应协议解析技术,仅需在配置文件中声明模型类型,即可自动匹配对应的通信协议。开发者通过标准化API即可完成对话生成、嵌入计算等操作。

实时范式升级:当某大模型突然升级API版本时,框架的动态加载机制可即时获取最新接口描述文件,避免系统被迫停机更新。

二、概念落地的"知识鸿沟".

RAG(检索增强生成)技术手册动辄上百页,但真正要在供应链系统中实现物料知识增强问答时,新手常陷入向量库选型、查询重写等细节迷宫。某电商团队曾因未正确处理文档分块策略,导致客服机器人频繁返回割裂的答案。

实战锦囊:

知识增强三步法:通过JBoltAI的RAGBuilder,可快速搭建"文档分块→向量化→混合检索"的增强链路。其智能分块算法能自动识别技术文档中的代码片段、参数表格等特殊内容,保证知识片段的完整性。

思维链可视化:框架内置的ChainTracer工具,可将大模型的推理过程分解为可观测的思维节点。在开发保险理赔评估系统时,这种可视化能力帮助团队快速定位到模型在责任认定环节的逻辑缺陷。

三、系统集成的"冰火碰撞" 当大模型遇上传统J2EE系统,火花四溅的不仅是技术栈差异。

某银行尝试在核心交易系统中引入AI助手时,就遭遇了SpringBoot与Python服务间的通信延迟难题,每秒千级的并发请求让gRPC连接频频超时。

融合之道:

混合架构适配器:JBoltAI的ServiceBridge组件支持Dubbo/SpringCloud双协议栈,可自动转换Tensor对象与Java实体。在智能投顾系统案例中,该方案将服务响应时间从800ms压缩至120ms。

数据血缘治理:框架的DataPipeline提供从Oracle到向量库的增量同步能力,通过智能schema映射技术,确保客户画像数据在进入大模型前自动脱敏并转换为标准格式。

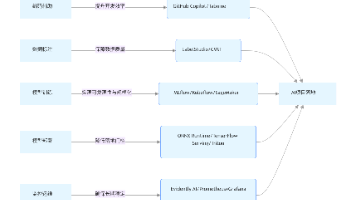

四、JBoltAI的全栈赋能 这个由国内团队研发的框架正在重塑Java的AI开发生态:

在模型层,其插件市场已集成15+主流大模型,支持私有化部署的专属模型一键接入

在应用层,开箱即用的Agent工作流引擎,可快速搭建包含意图识别、知识检索、风险过滤的智能对话系统

在运维层,智能限流模块能根据GPU负载动态调整并发请求,配合prompt注入检测功能,为系统保驾护航

某大型制造企业的实践印证了其价值:借助JBoltAI,其设备故障诊断系统的开发周期从6个月缩短至45天,准确率提升37%的同时,首次实现AI服务与原有MES系统的毫秒级交互。

大模型应用的战局已进入深水区,Java开发者既要保持对技术本质的洞察,更需要像JBoltAI这样 的"战术背包"。当框架处理好底层复杂性,开发者便能专注于创造真正的业务价值——这或许正是AI时代Java生态进化的最佳注脚。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)