基于linux服务器Ubantu20.04的离线Ollama安装(手动安装成功)

链接: https://pan.baidu.com/s/1e9Tke5t-x5YIw1iuPvBb5Q?注意:检查 /usr/ollama 目录下的文件结构,确认有可执行文件ollama后在运行命令:ollama -v。注意ollama.service的ollama可执行文件位置,要按照自己的去写,见下图红色方框内容,需要自定义。到此,基于Ubantu20.04的离线安装ollama并拉取qwen

1、下载对应的tar包 linux-ollama-amd64.tgz

——————————————————

资源自取,百度网盘

通过网盘分享的文件:ollama-linux-amd64.tgz

链接: https://pan.baidu.com/s/1e9Tke5t-x5YIw1iuPvBb5Q?pwd=wcba 提取码: wcba

–来自百度网盘超级会员v1的分享

————————————————————

2、将下载好的tar包利用winSCP传输到linux服务器指定路径上

我的路径是:/resource

这里自定义,由自己去选择

创建新目录或者更改目录可以用winSCP图形化界面操作

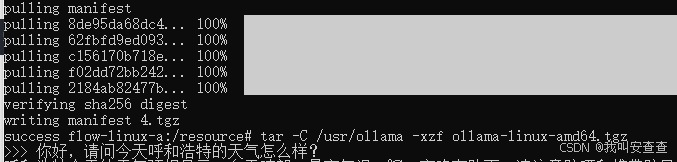

3、tar命令解压缩部署ollama加粗样式**

tar -C /usr/ollama -xzf ollama-linux-amd64.tgz

Notes:-C后面加的是ollama部署路径

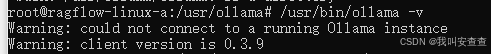

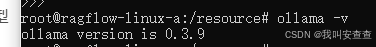

检查ollama是否安装成功

此处使用绝对路径运行(如果想用相对路径,需要设置环境变量,参考另一篇博文)

/usr/ollama/bin/ollama -v

注意:检查 /usr/ollama 目录下的文件结构,确认有可执行文件ollama后在运行命令:ollama -v

——————————————————————

可能的报错

——————————————————————————

放心,继续下面步骤就会解决

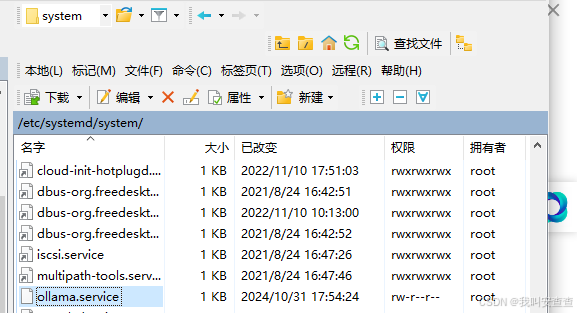

4、创建服务文件/etc/systemd/system/ollama.service

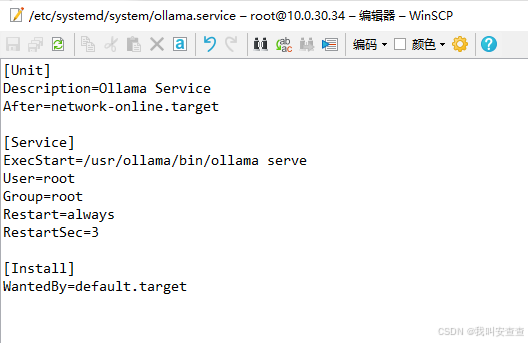

按照上面路径新建文件ollama.service将以下内容粘贴进去

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

Environment="OLLAMA_HOST=0.0.0.0:11434"

ExecStart=/usr/ollama/bin/ollama serve

User=root

Group=root

Restart=always

RestartSec=3

[Install]

WantedBy=default.target

这里有个小tips,如果你是下载了winSCP的话,那么非常棒,它会给提供Linux可视化文件操作界面,便于传输文件和操作文件,比如创建ollama.service可以利用winSCP的编辑软件,不用Liunx自带nano编辑器和vim编辑器,操作简单了不少。效果图如下

winSCP文本编辑器

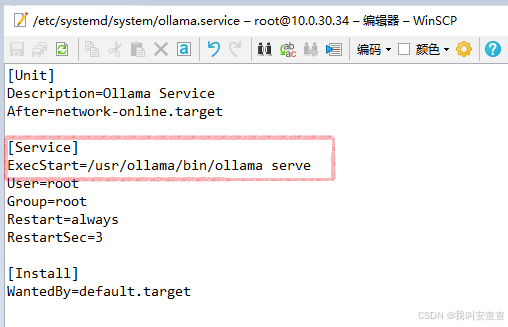

注意ollama.service的ollama可执行文件位置,要按照自己的去写,见下图红色方框内容,需要自定义

保存ollama.service后执行以下命令:

生效服务命令行:

systemctl daemon-reload

服务自启动:

systemctl enable ollama

启动服务:

systemctl start ollama

再次运行 ollama -v

出现版本信息 成功!

三、Ollama上运行大模型

拉取阿里巴巴的通义千问qwen2.5版本的大模型

ollama run qwen2.5

拉取成功的界面,进入对话

到此,基于Ubantu20.04的离线安装ollama并拉取qwen2.5大模型成功完成。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)