手把手教你本地部署DeepSeek R1大模型:Ollama+ChatBox可视化全攻略

为了更便捷地与模型交互,摆脱命令窗口的限制,你可以安装ChatBox这一可视化界面工具。安装完成后,即可开启与DeepSeek R1的轻松对话之旅。🎉 现在,尽情享受本地大模型的魅力吧!✅ 全平台兼容:Windows/macOS/Linux无缝适配(含M1/M2芯片)✅ 模型生态丰富:支持Llama3、DeepSeek等主流开源模型。✅ 零代码交互:命令行+可视化界面双模式自由切换。✅ 极简安装

·

🚀 前言:为什么选择Ollama?

✅ 极简安装:3分钟完成本地大模型环境搭建

✅ 全平台兼容:Windows/macOS/Linux无缝适配(含M1/M2芯片)

✅ 零代码交互:命令行+可视化界面双模式自由切换

✅ 模型生态丰富:支持Llama3、DeepSeek等主流开源模型

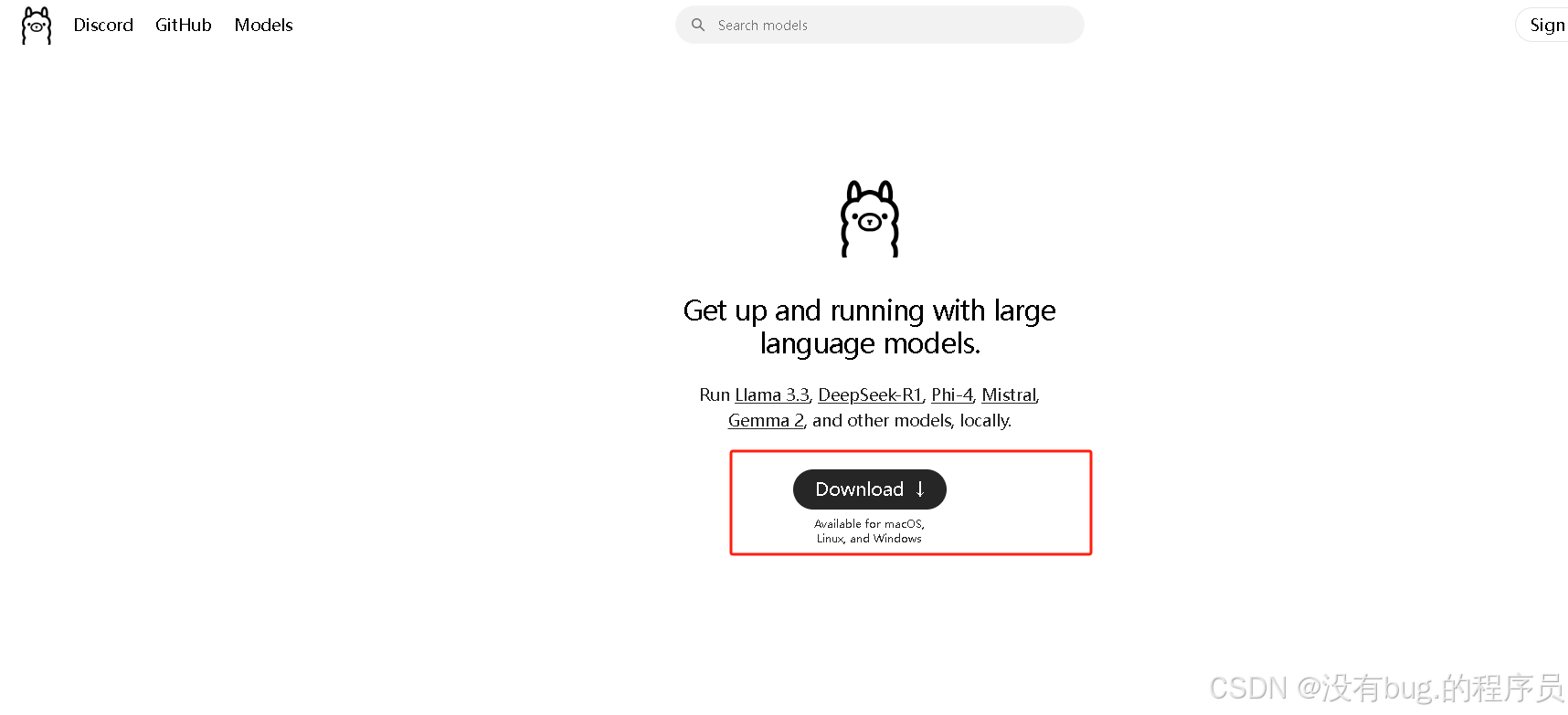

📥 第一步:Ollama安装全流程(Windows为例)

- 一键下载安装包

访问官网 → https://ollama.com → 点击 Download

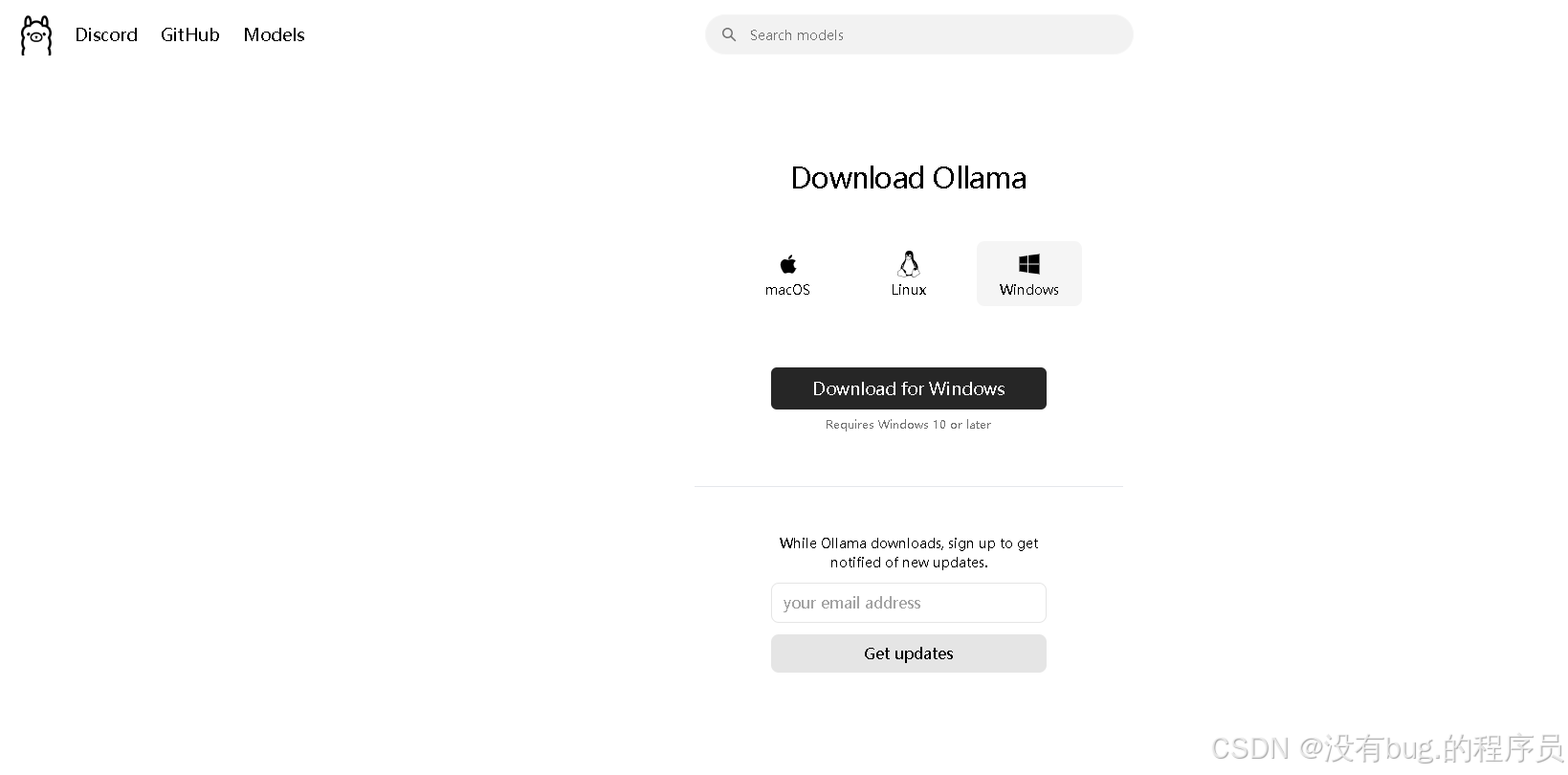

选择对应系统版本(图示Windows/macOS/Linux按钮)

- 三步完成安装:

(1)双击下载的.exe文件

(2)保持默认设置 → 连续点击 “Next”

(3)安装完成后,系统托盘出现🦙图标即表示成功

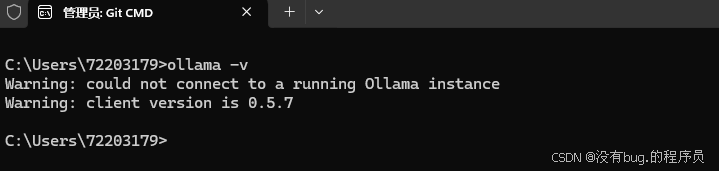

- 验证安装:安装完成后,打开命令行窗口,输入以下命令:

ollama -v

- 预期输出:ollama version 0.5.7(2024年最新版本)

- ❗ 若版本过低:运行 ollama update 获取更新

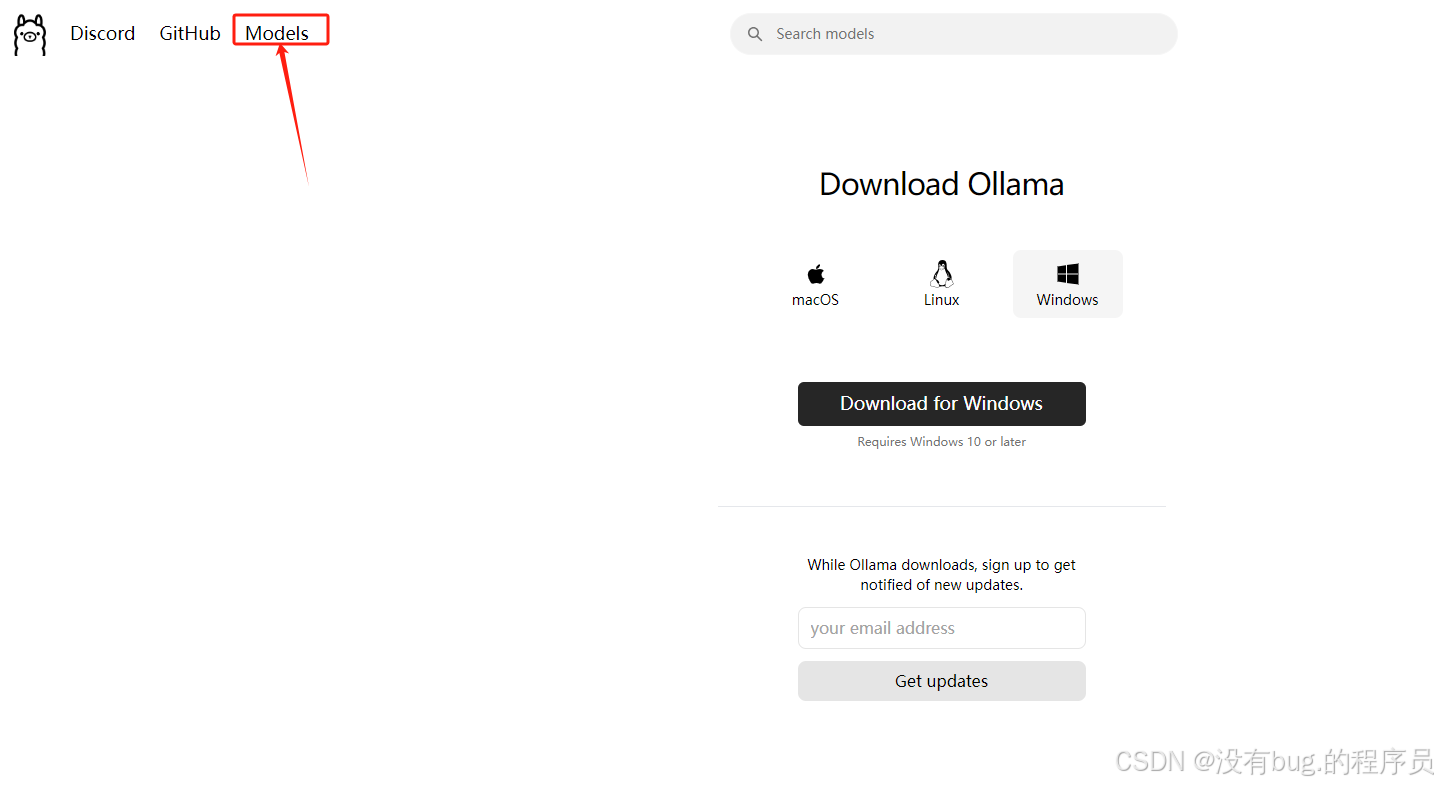

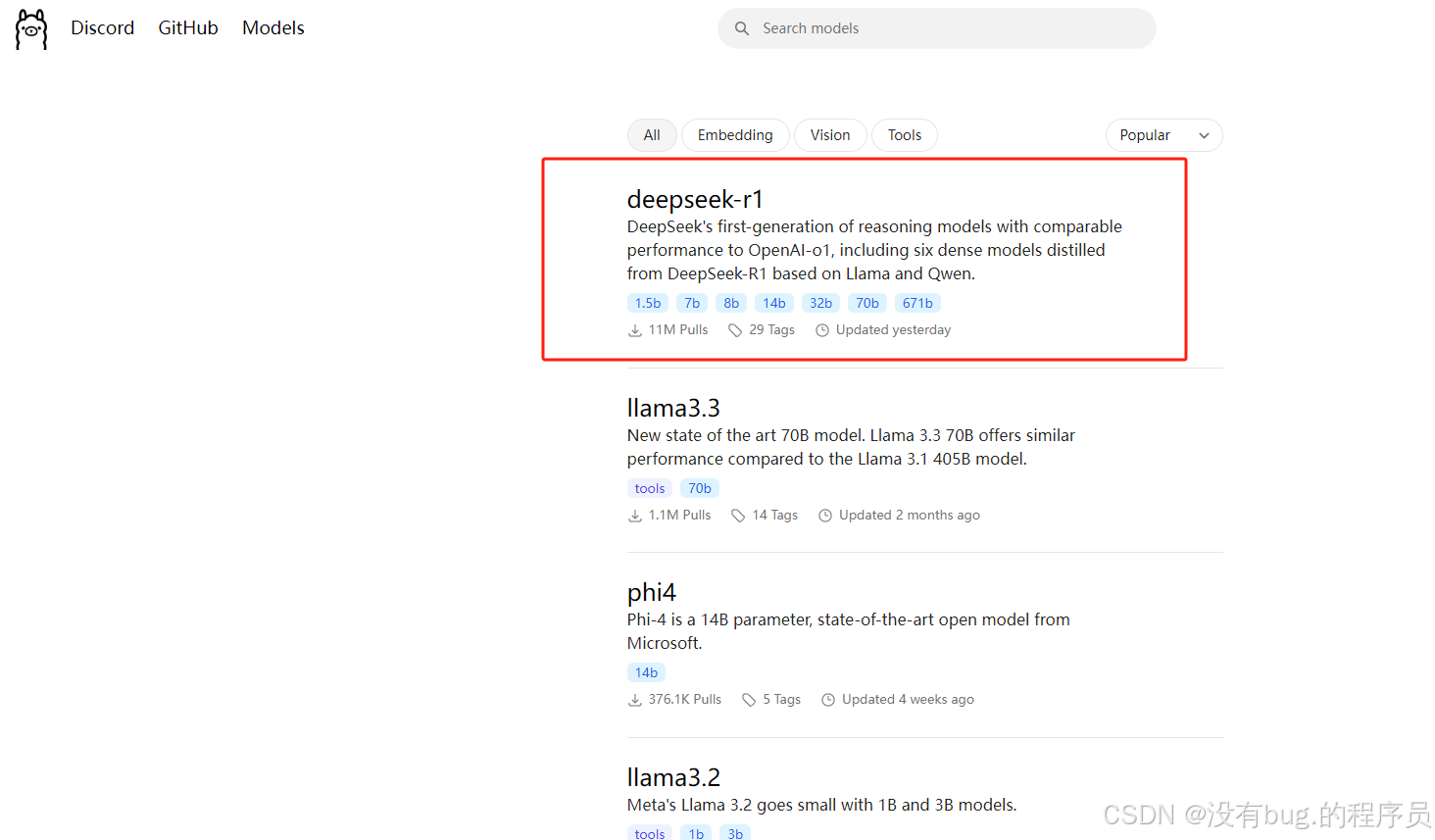

🤖 第二步:DeepSeek R1模型部署

1.模型特性速览

- 性能对标:OpenAI GPT-3.5级别推理能力

- 硬件需求:7B版本需 8GB+内存(推荐16GB)

- 适用场景:代码生成/文案创作/逻辑推理

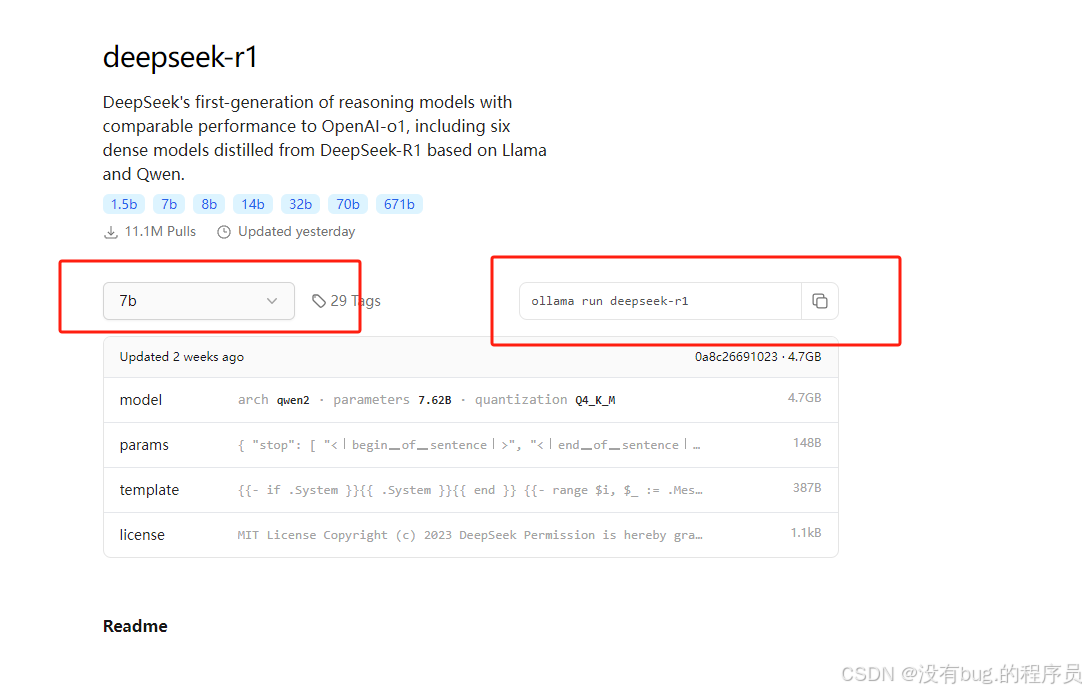

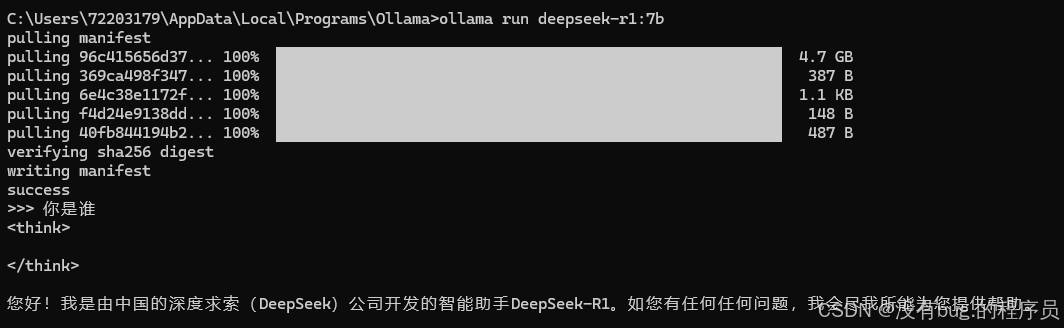

- 一键拉取模型

ollama run deepseek-r1:7b

- 首次运行自动下载(约4.2GB)

- 💡 多版本选择:

- :7b → 基础版(内存要求低)

- :13b → 增强版(需16GB+内存)

下载完成我们就可以用命令行进行对话了

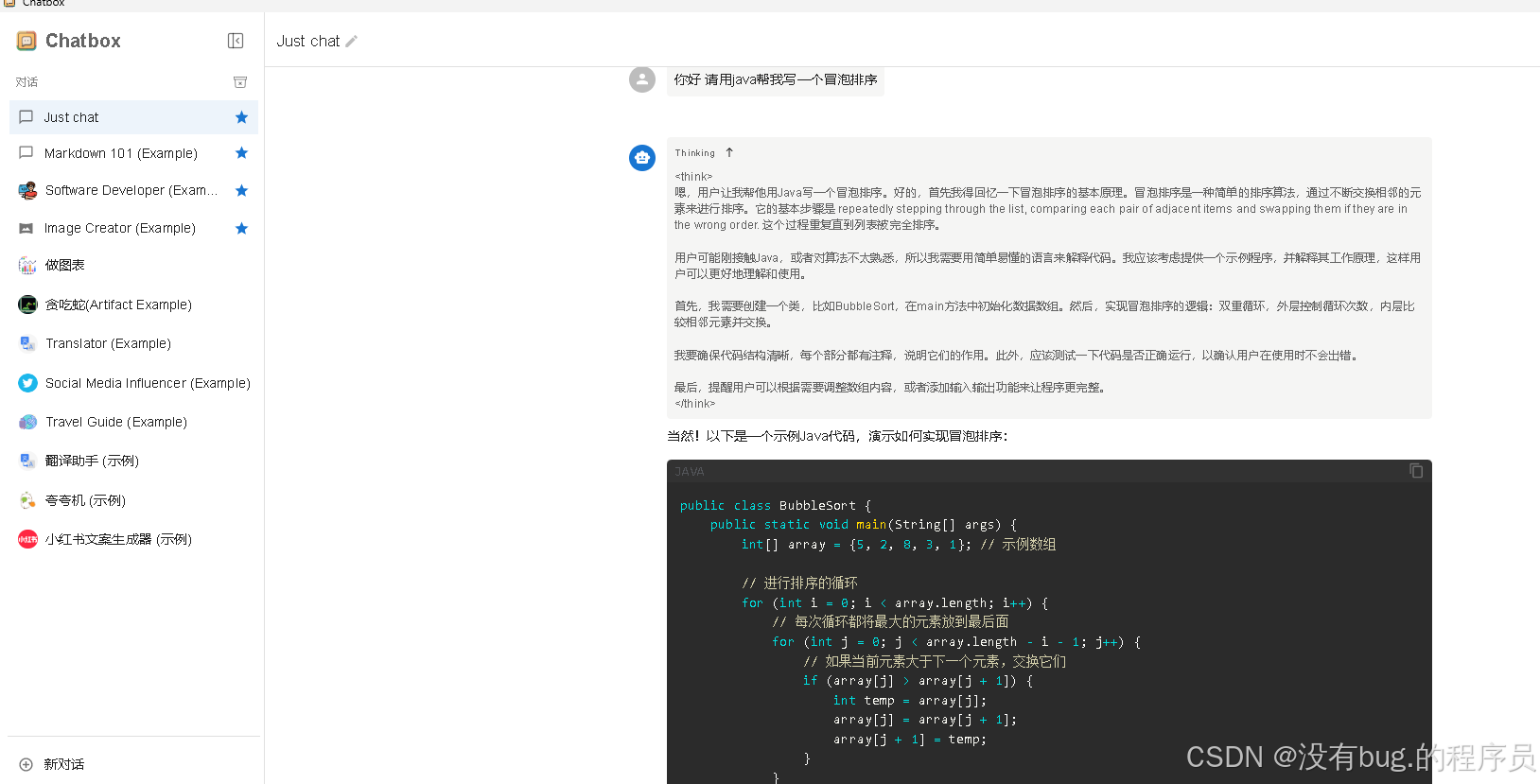

🖥️ 第三步:ChatBox可视化交互(小白友好)

为了更便捷地与模型交互,摆脱命令窗口的限制,你可以安装ChatBox这一可视化界面工具。安装完成后,即可开启与DeepSeek R1的轻松对话之旅。

- 下载安装

- 官网:https://chatboxai.app/zh

- 支持Windows/macOS/Linux(选与Ollama相同的系统版本)

- 30秒配置本地模型

- 打开ChatBox → 点击右下角 ⚙️设置

- 选择 “本地模型” → API地址填 http://localhost:11434

- 模型列表选择 deepseek-r1:7b

3. 开始对话

- 支持多轮对话/Markdown渲染/历史记录保存

🔥 进阶技巧:提升使用体验

- GPU加速:

- NVIDIA显卡用户安装CUDA驱动 → 运行效率提升300%

ollama run deepseek-r1:7b --gpu

- 自定义模型库:

- 修改Ollama默认存储路径(避免C盘爆满)

setx OLLAMA_MODELS "D:\AI_Models"

- API开发调用:

import requests

response = requests.post(

"http://localhost:11434/api/generate",

json={"model": "deepseek-r1:7b", "prompt": "你好!"}

)

print(response.json()["response"])

❓ 常见问题解答

Q:模型响应速度慢怎么办?

- A:尝试量化版模型(如deepseek-r1:7b-q4)或关闭其他内存占用程序

Q:如何查看已安装模型列表?

ollama list

Q:支持中文对话吗?

- ✅ DeepSeek R1原生支持中英双语,无需额外配置

🎉 现在,尽情享受本地大模型的魅力吧! 遇到问题欢迎在评论区留言,我会第一时间解答~

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)